数据优化的游戏运营思考路径 · 3个案例用数据留住用户

公众号:数数科技

立志要在互联网闯荡的运营专员抓耳挠腮地在电脑面前看着看板数据,用户量下滑,留存营收莫名其妙地下降,老板指着一个月比一个月难看的数据说你不适合这个岗位。

对于运营来说,这个岗位可以像地球一样分三个层面:

地核:用户

地幔:用户在产品中的行为

地壳:行为在产品中产出的数据

地壳部分的数据瞬息万变,各个新运营人们在产品的新大陆上总是在措不及防之时,就被身旁名为“次留”或者“流失”的活火山给弄得焦头烂额。

这些变化似乎难以把控,“用户”的本质地核深藏在地壳下方,新人们只能在发现数据异常的时候赶紧收集,却很难预知未来可能会发生的事情。

但一切数据的产生都是有其原因的。用户是产品调性固定住的东西,产生出数据的用户行为便是运营应该牢牢抓住的东西。

抓住用户行为的过程,便是我想要传达给大家的思维——数据分析&挖掘

下面我会通过概述和三个案例来阐述这种思维的方式:

- 案例1:关键词数据抓取优化

- 案例2:漏斗-对比优化

- 案例3:数据预测计算思路

数据分析&挖掘

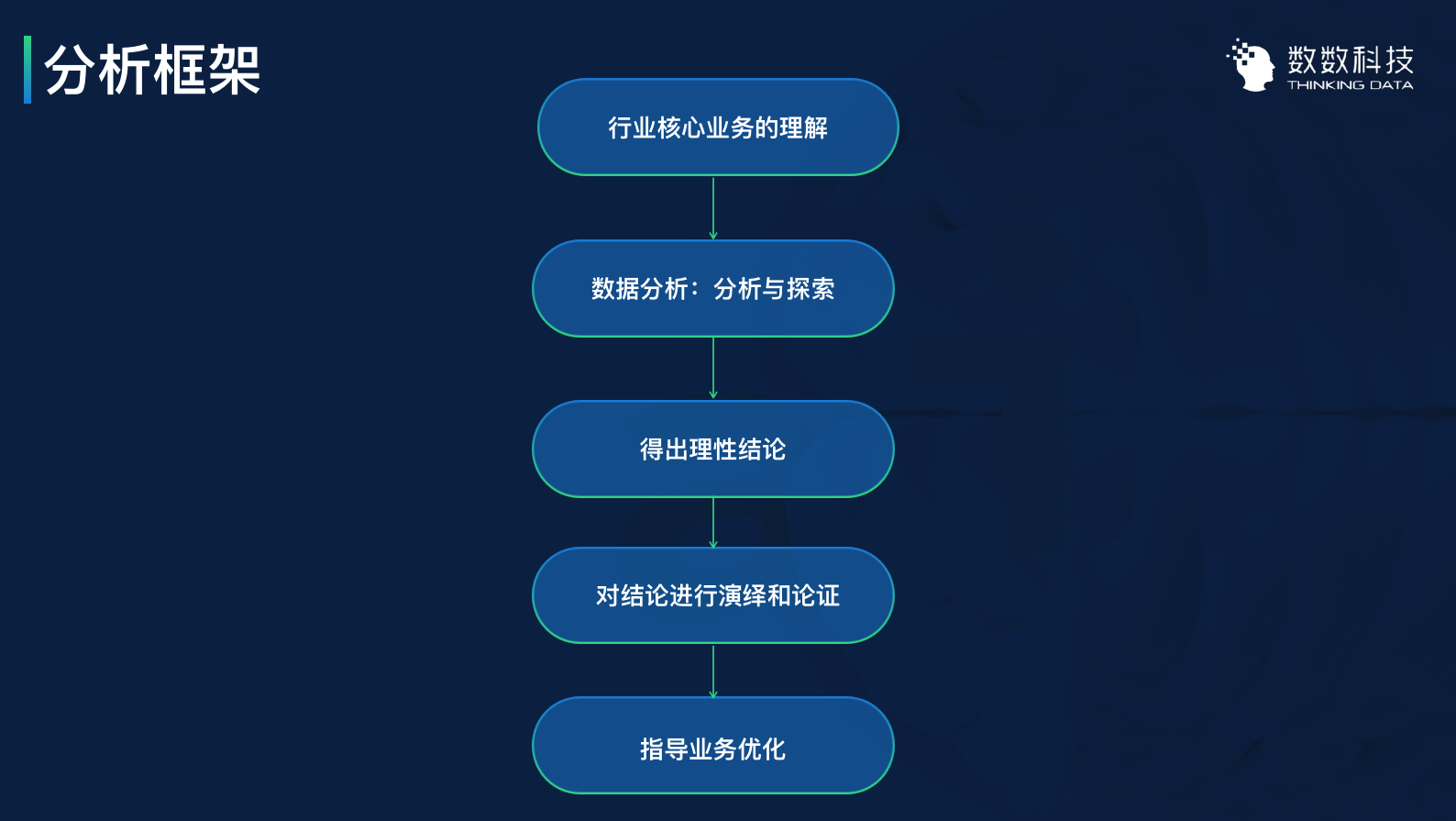

数据分析并非信手拈来的,数据分析是有其一定的框架可遵循的。

数据分析的框架可以分为3个主要步骤:

- 理解行业业务

- 将数字转化为结论

- 结论的验证与实践

1. 理解行业业务

对任何问题的优化,其前提都是对行业业务及岗位需求有着基本的理解。

数据只有依附在实际业务上,才能从概念转化成具有实体意义的内容。

2. 将数字转化为结论

数据分析是一个分析+探索的过程。我们有时是带着问题和假设去分析、验证,有时是纯粹地在数据中探索,但无论怎样的形式,我们都需要数据将我们导向一个理性的结论。

获得理性结论是一个非常关键的环节。当我们跟一些同行交流下来,大家在做数据分析的时候经常得出一些看上去很正确的结果,但这些结果其实对业务指导的价值却很小。

这样的结果是因为分析还不够深入,并且没有把握住业务核心,才会导致看上去很正确的观点,在实际的指导中却没有很好的效果。

3. 结论的验证与实践

获取结论后,我们可以尝试将理论投入实践:

- 演绎论证已有结论

- 利用结论去优化业务

对结论进行演绎和论证,是从多维度证明我们的结论的可操作性。

通常我们可以用其他产品的已有数据去佐证这个结论,我们也可以在无数据的情况下,开展产品的版本AB测试来收集数据,去实验、验证结论的可行性。

无论是用什么样的方法,都是为了证明数据获得的理性结论,是能够实际且有效地指导业务完成优化。

数据分析三个通用思路

在梳理完数据分析框架后,我们转向数据分析思路。数据分析思路并没有优劣之分,不同的分析场景需要不同的思路去应对,这里我列举了三个通用的基本思路:

- AARRR

- RFM

- 5W2H

1. AARRR——海盗模型

一个产品自上线开始,AARRR模型便从用户获取、留存激活,再到营收传播等流程,贯穿了产品&用户联系的全链过程,整体用户进入产品后产生的每一板块的数据都是分析点。

AARRR的思路比较适合分析产品的整体情况。特别是产品还处于早期测试阶段的时候,我们就可以用这个思路去做产品的场景分析,从每一步的场景模拟去找到产品优化改进的点。

2. RFM——用户价值分析体系

RFM是用户价值的分层、评估体系。

我们在传统的用户分群模式中,将用户直接分为:大R、中R、小R,按照累计的充值金额去粗暴地做用户划分,很难在这个基础上做到更加精细化的策略应对。

RFM就给出了比较全面、有规范的分层模式,可以把用户分群为,例如高价值、中等价值、潜在价值等等层次。依据RFM给出不同层次的用户需求,我们可以为不同的用户策划出更为精细化的运营策略。

3. 5W2H——分析的基层框架

5W2H是最为常见的事件分析思路。

我们在做数据分析的时候,其实大部分处理方式的底层思路,均可归属到5W2H的思路。

我们会去梳理:

- 发生了事件?

- 事件发生在哪里?

- 什么时候发生的事情?

- 事件的关联群体?

- 事情是发生的理由?

然后根据5W获得事件处理方案:

- 我们该如何处理?

- 我们的事件处理程度?

这是一个比较宽泛,同时也是经常用到的分析思路。

实际案例分析

1. 宝箱优化——如何利用简单、显眼的数据

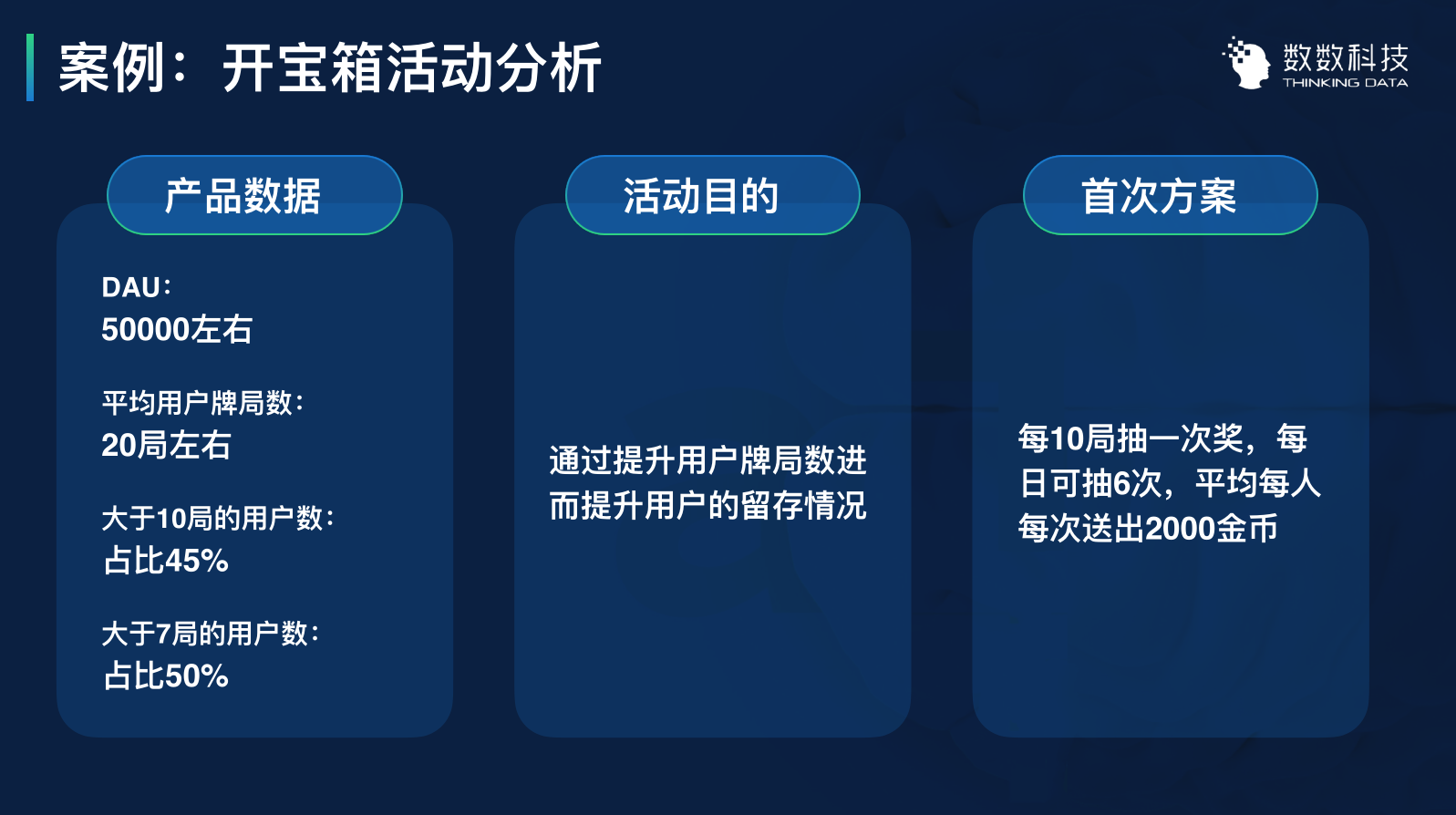

这个棋牌产品正准备第二次开宝箱的活动,主要目的是希望通过宝箱活动去实现玩家在线时间及ARPU的提升。

经过第一次宝箱活动后,该产品目前的数据是这样的:

第一次活动策划的时候我们是没有可对比的活动数据作为参考的,我们选择了“大于10局的用户数占比45%”的结论去策划活动。

到了第二次活动策划,我们制定了活动的策划思路:

- 进一步增加活动参与度

- 控制游戏成本输出(用户金币均获取量)

根据这两个思路,我们制定了第二期活动的改进方案。

这次改进中,我们改进了两个活动点:

(1)降低参与门槛——提升活动参与度

此次活动最大的变动,便是从10局一次开宝箱的机会,改成了7次。这个调整的数据依据就是“大于7局的用户数占比为50%”。

这个改进依据是最容易发现的,同时也是最关键的。

(2)上调服务费——控制成本

为了吸引更多用户参与活动,我们降低了抽奖门槛,并提升了奖励金额。但是为了控制成本输出,我们上调了服务场的服务费用,导致尽管玩家表面上更容易获取资源,且资源数量不少,但实际获取的金币数量是低于第一次活动的。

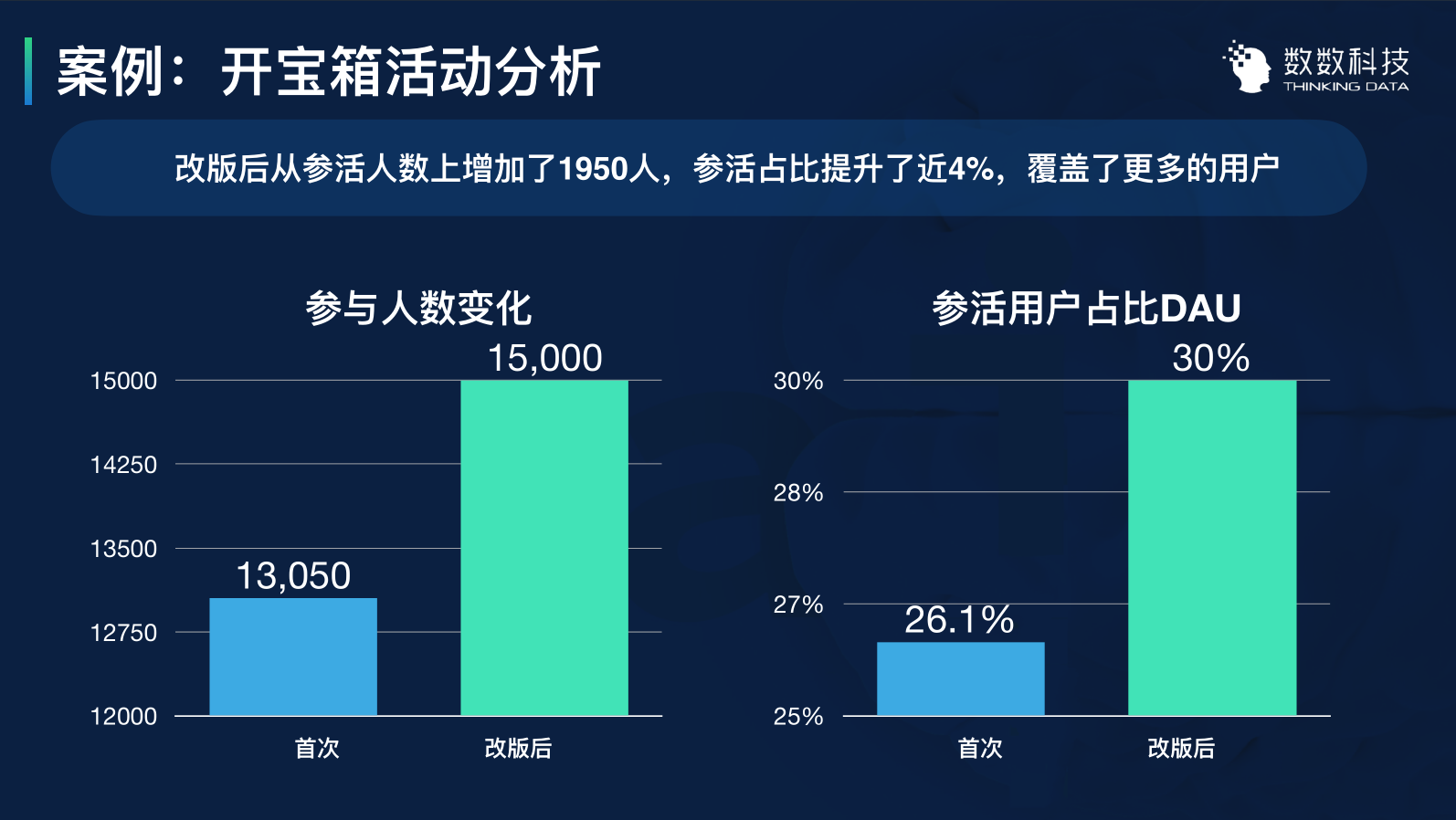

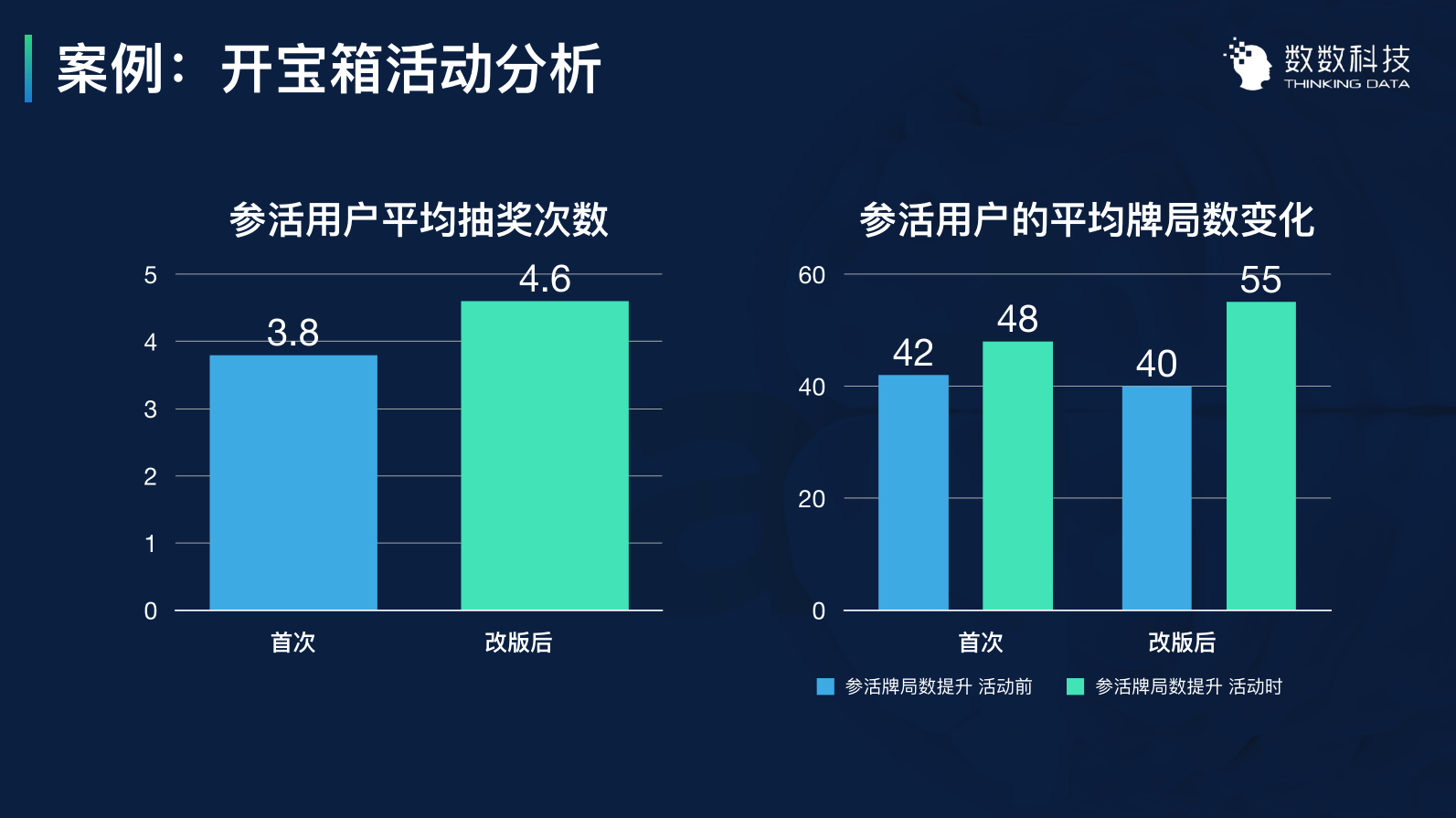

改动之后,活动的参与人数的数据变化如下图:

从抽奖次数来看,参活用户平均抽奖次数从3.8提升到了4.6。

这个数据说明,门槛的降低促使更多的用户参与抽奖,且抽奖频率相较一期有了较为明显的提升。

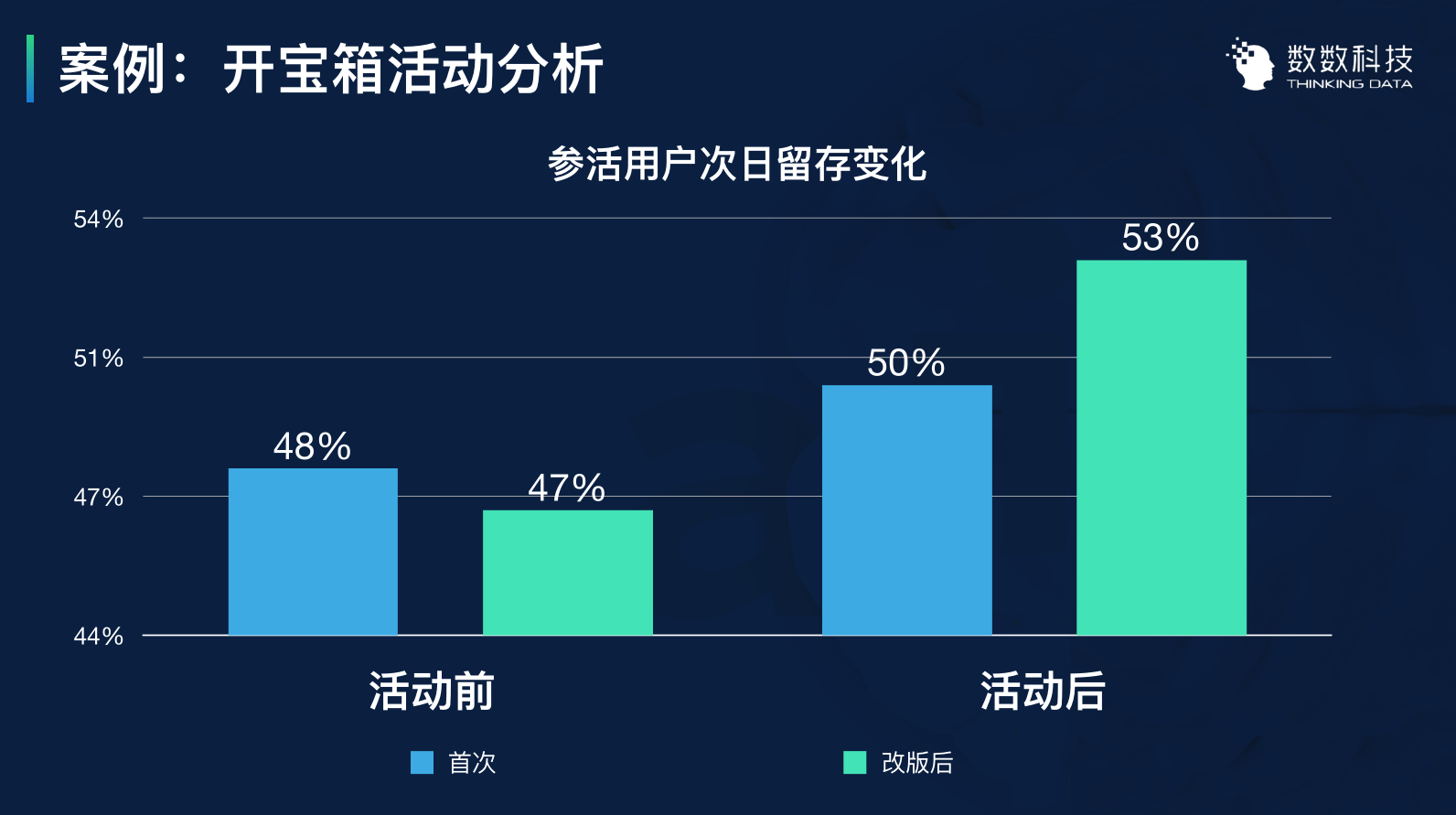

另外,活动的最终目的是为了提升游戏留存,两期活动前后留存的情况是这样的:

数据显示,第一期活动将产品留存率是从48%提升到了50%,提升了2个百分点。第二期的用户留存从47%提升到了53%,提升了6个点。

这个数据结果就是非常好、有效的活动效果。

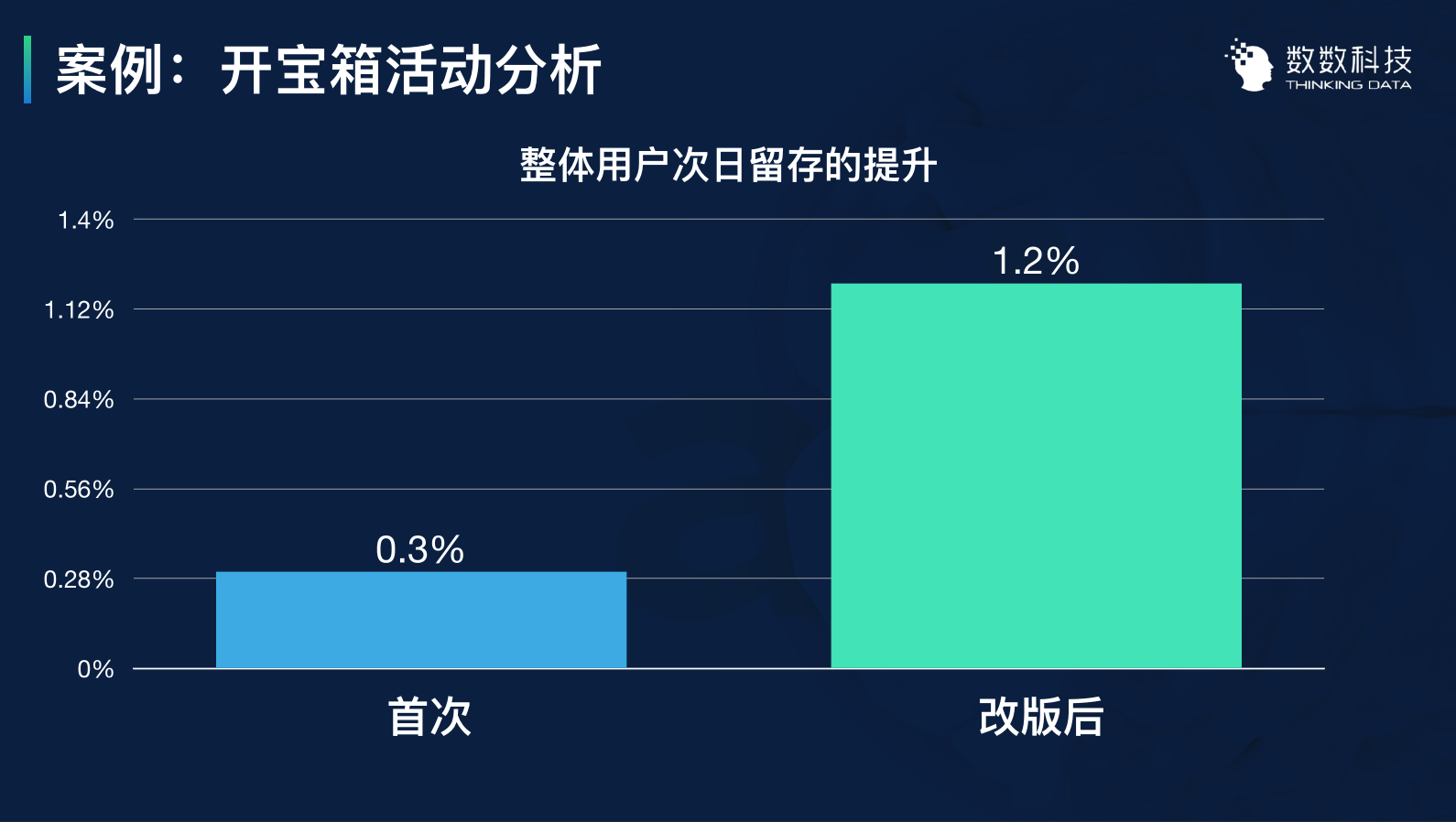

而从整体用户的次日留存提升来看,留存数值从0.3%提升到了1.2%。如果我们能够将产品的留存提升1%的话,这个活动对产品产生的价值是非常高的,留存数据也会进一步影响到整个用户的LTV。

通过这个活动的分析,我们可以看到活动策划的一个源头:关键的数据。

二期活动利用一个非常简单的变量——10局到7局的改良,使得活动效果获得了大幅度的改进。

很多时候我们会把数据分析想得过于复杂,但其实我们可以利用最简单且明显的数据就能做到非常显著的优化效果,并且这样的数据其实非常多。

这是我想通过这个例子向大家呈现的一个概念:抓住简单而又关键的数据。

2. MMORPG召回活动

我们再来看看一款MMORPG产品的召回活动。

和许多处于中后期运营阶段的产品一样,这款MMORPG的流失用户会在这个阶段去开展召回流失玩家的活动,并策划相应的召回活动去提升这些玩家的留存。

玩家的召回方式有很多,常见的有短信、邮件、客服等方法。短信信息召回是性价比最高的方法之一,这款案例产品的活动也是通过短信来实现的。

但因为召回人群的差异,短信内容也要发生变化。首先对流失可召回的玩家可以进行几个分层,如图示内容,核心用户、高端用户、次高端用户、中端用户、低端用户123。

这是两次召回活动的数据,数据包含了失败、成功、目标召回以及召回率。

如果从活动召回率来说,第一次活动总的召回率是15%,第二次是20%。召回率反映出第二次的效果是明显比第一次好的。

但如果我们再来仔细看整个数据的召回率比例,我们会发现第二次召回的用户中,之所以会比第一次的召回率高,数据的提升更多体现在低端用户的召回上。

因次第二次活动的召回效果是否真的好。我们需要看更多的数据和指标来佐证,到底哪一次的活动举办的比较成功。

因此,我们选择以下几个点进行分析:

- 回归天数分布

- 资源消耗对比

- 分类型用户占比

- 回归后30天内登陆不足20天的用户

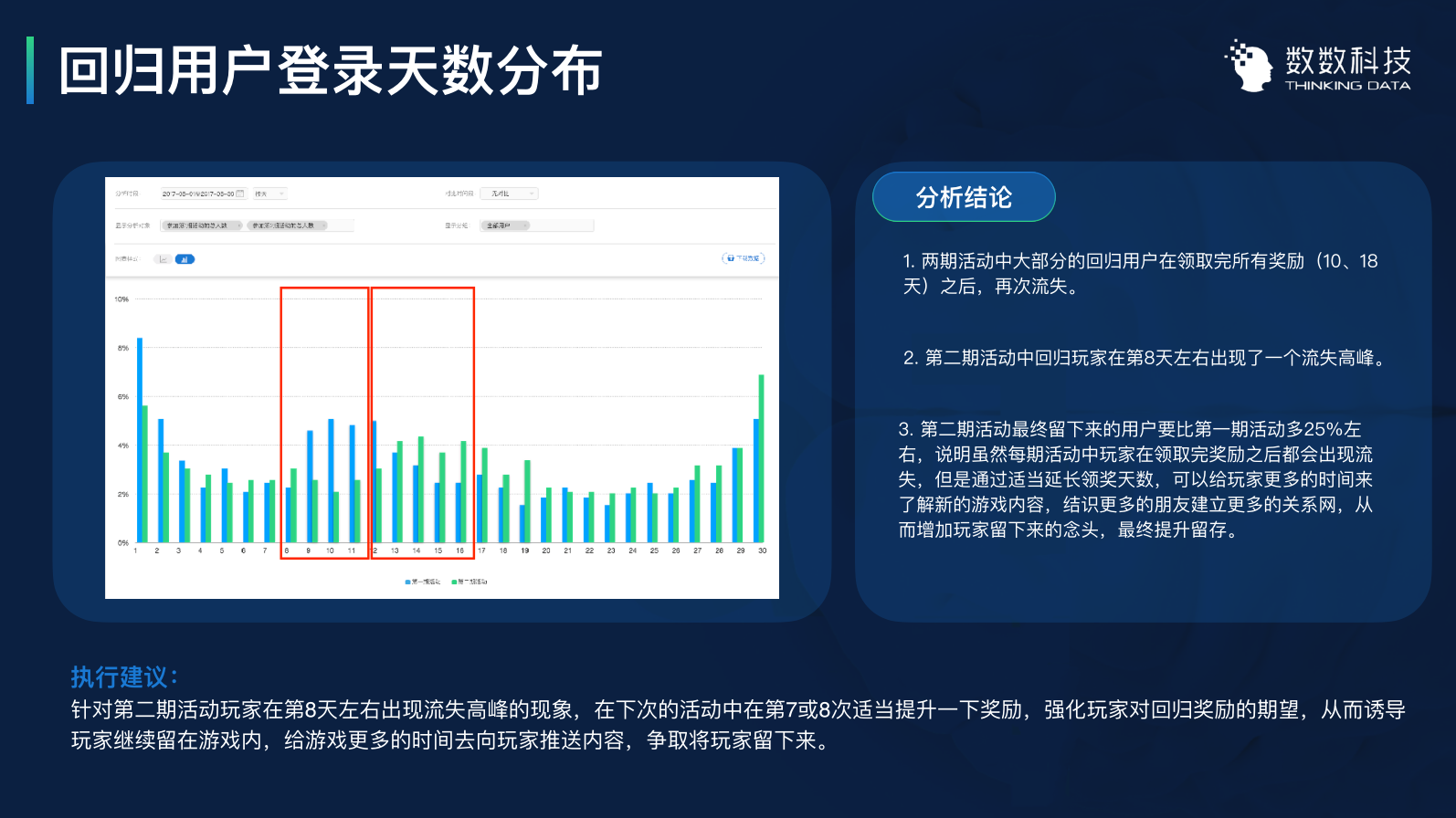

(1)回归天数分布

对于回归用户登录天数分布,就是回归用户在30天之内活跃了多少天。下图是第一次活动和第二次活动的用户活跃天数分布。

第一次活动形式主要是发短信让老玩家回来,利用每天签到领奖提高留存,并在第十天的时候用大奖的形式提高用户的长线留存能力。

第二次的时候,召回活动同样也是每天都可以领奖,但是我们将大奖的领取时间拉长,让用户在第十八天的时候才可以领取。领奖时间的差异,导致数据上产生了差异。

根据这个表我们可以找出一些现象:

- 大部分回归用户领了大奖后就基本都流失了。30天为周期,用户登陆数据基本都是在15天左右开始下去。

- 回归的用户在第八天的时候出现了一个流失的高峰。这是一个需要关注的点。因为在第一次活动的时候,第八天并没有出现高流失的情况,因此,第八天的数据异常应该可以挖掘出一个对活动改进的点。

- 第二期活动留下来的用户要比第一期留下的要多

二期活动回流用户要比一期多25%左右,证明用户虽然领了奖品大多会流失。但是通过延长活动奖品的领取时间,可以让玩家有更多的时间去了解游戏的内容。

很多MMORPG是通过社区互动的方式,例如师徒系统、组队副本等方式,提高了召回玩家的留存。

所以我们可以得到一个改进结论:

就是针对第二期活动,召回玩家在第八天左右出现流失高风现象,下一次召回活动应当在第7第8天来适当地提升奖品奖励,来提高用户期望,从而促使玩家继续留在游戏当中。当然,这个结论也需要从更多的维度去佐证是否成立。

我们对召回的玩家不仅要关注他们的召回率,我们还应当去关注他们的活跃度。

(2)资源消耗对比

召回的本质还是想让玩家留下来,留下来之后开始消费的行为。

由图可知,第二次召回的用户的资源消耗(付费能力)要高于第一期的用户,由日均1.8提升到1.9,提升了6%。同时,结合游戏的付费数据,同期游戏日均首日分别为300和240,可以看到第二期活动从营收上的确是要高于第一期活动的。

我们刚刚看到召回活跃度的对比,召回玩家的活跃度是第二期更好的,从充值和资源消耗来说,也是第二期更好一些。分析到这里的时候,我们其实基本可以下结论,第二期的召回活动效果是优于第二期召回活动的。

分析到这里,其实我们还没有得到更多建议,去优化第三期的召回活动。因次我们还需要去深挖用户行为路径,去发掘用户的价值。

(3)分类型用户占比

首先,是分类型用户消耗占比的分析,我们本身在召回的时候把用户分了不同的层级,高端、次高端之类的概念。这些用户回归游戏后,我们针对他们在游戏内分别消耗了多少资源做了一个对比的分布图,这个时候我们可以明显地发现一些特别有价值的结论:

回归玩家消耗明显集中在高端用户和低端用户1中。

在两期的活动中,低端用户1分别占据了消耗占比的44%和36%,均远高于其他类别的玩家的。

其实一期活动策划的时候,我们的活动大部分都是希望去把高端+次高端用户作为我们的活动导向核心,因为这些都是大玩家的贡献价值更大。

但实际上,这两期活动对低端用户1和次高端用户的影响最大,后面如果我们要再策划类似活动的话,我们就应当需要对低端用户1做一个更为全面的分析,让活动可以进一步挖掘这部分人群的消费能力和体验导向。

同样的,其他的用户行为需求我们也需要进一步的分析,对整个活动进行改良,以提高活动对其他用户的吸引力。

综上所述,活动对我们的核心用户群——高端用户&次高端用户,其实吸引力是不大的。

这里就可以获得两个结论:

- 回归玩家的消耗主要来⾃于次⾼端⽤户和低端⽤户1,尤其是低端⽤户1,此类玩家在两期活动的消耗中分别占到了44%和36%。作为召回活动主要召回对象的核⼼⽤户和高端⽤户反⽽没有表现出较强的付费能⼒。

- 低端⽤户3类型消耗占⽐第⼆期有较⼤幅度提升,由3%提升到了12.7%,说明虽然此类⽤户中有⼤量的⼩号、仓库号,但其中真实⽤户仍然能够给游戏带来⼀定价值。

由上述结论便可以导出对第三期活动的改进建议:

适当提升次⾼端⽤户和低端⽤户1的奖励价值,因为这两类玩家具有更强的消费能⼒和倾向,适当提升奖励价值可以达到提升其消费意愿的作⽤。

这是对用户进行分类的对比,我们还可以看回归之后30天之内,登陆不足20天的用户,从中再去发掘更多数据信息。

(4)回归后30天内登陆不足20天的用户

这个用户就是召回之后再次流失,他们回来之后为什么又走了,这里其实是需要结合整个游戏的玩法去分析了。

比如说低端用户3的等级分布,它的流失点分别为65级及70级,这里要结合游戏的玩法去分析这两个点存在什么样的问题导致玩家流失。

对于这个游戏来说,65级和70级的时候有一个要求较高的飞升系统。前期在召回玩家回来之后,我们会奖励玩家一些经验值和奖励的礼包,但到了飞升的时候会卡在这里,这个点也会成为未来活动优化的方向。对于低端用户2也可以同样使用这样的思路去分析优化。

使用这种分析,我们可以得到一些结论。就是我们在做活动结果的数据分析的时候,我们很容易只停留在活动的数据表面,并没有对下层行为做一个深钻,如果我们从不同的角度去深挖数据,我们就可以得到很多有价值的点。

数据挖掘

数据除了数据分析的价值,另一层价值就是数据挖掘的价值。

数据分析是依赖于人的经验及人对业务的理解,依赖人的逻辑思维能力去找到整个业务相关的信息,去找到理性且可以指导我们产品优化的点。

数据挖掘就是从另外一个维度去发掘数据的价值。

我们这里用一个比较简单常见的案例:产品的DAU预测。通过这个案例,我们可以看到数据挖掘的一个思路。

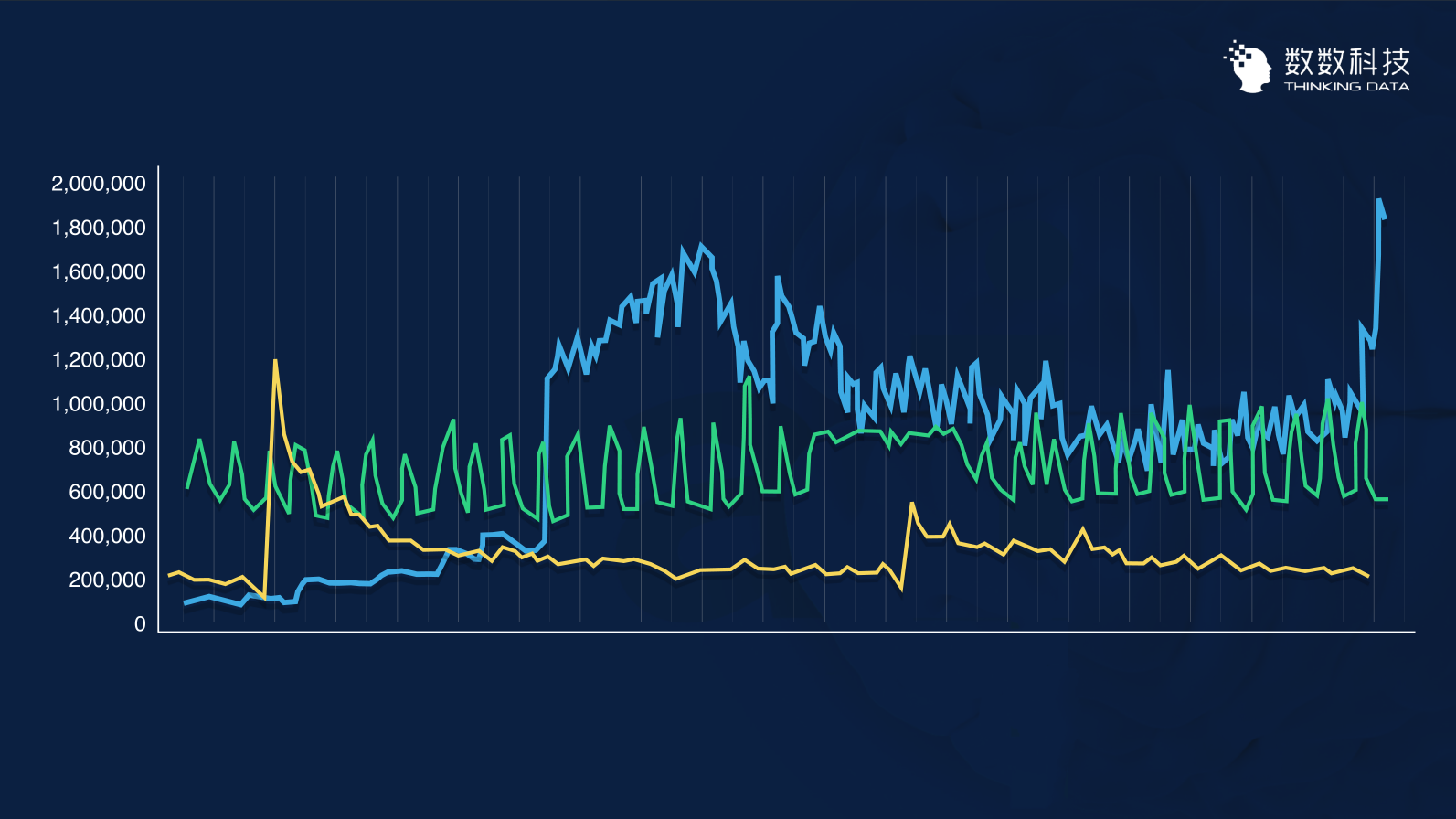

这里有三条曲线,分别代表了三个产品的DAU,三个DAU走势波动比较厉害,而有一些的周期性比较明显,没有太多规律可言。

我们就需要一些比较科学的方法去预测DAU、分析产品的DAU、分析具体的场景去对我们的一些产品决策进行辅助。

比如说这个场景:

现在有一个产品公测没多久,公司给的KPI指标是产品投放后能够达到50万的收益。事实上,在产品上线的两周,产品的数据已经很接近50万,但是一直徘徊在45-47万。

这个产品本身没有达到50万DAU的KPI,这个时候整个项目组还有一笔预算,需要去衡量这笔预算如果全部拿去买量的话,能不能达成这样的一个KPI。

这个时候我们需要找到一个可以科学决策的依据,我们要分析整个DAU跟新增用户的关系,去分析多少钱可以获得大概多少的市场新增。

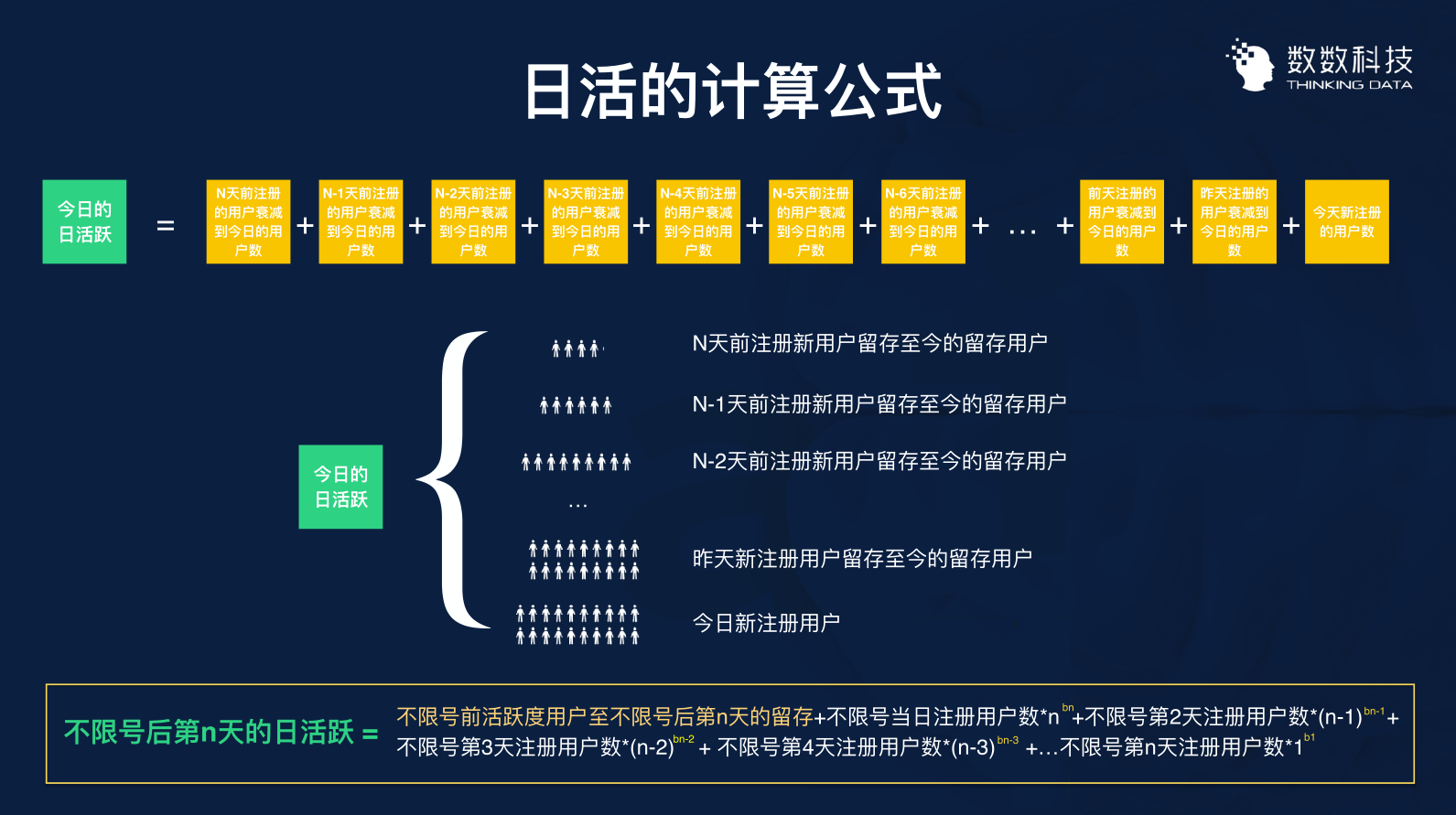

新增和DAU并不是一个直接的关系,中间通过留存做了一个桥接,所以我们需要分析新增和DAU之间的关系是什么,如果我们能够得到一个公式去计算出来的话,就能够倒推我们需要花多少钱才能够满足50万的KPI。

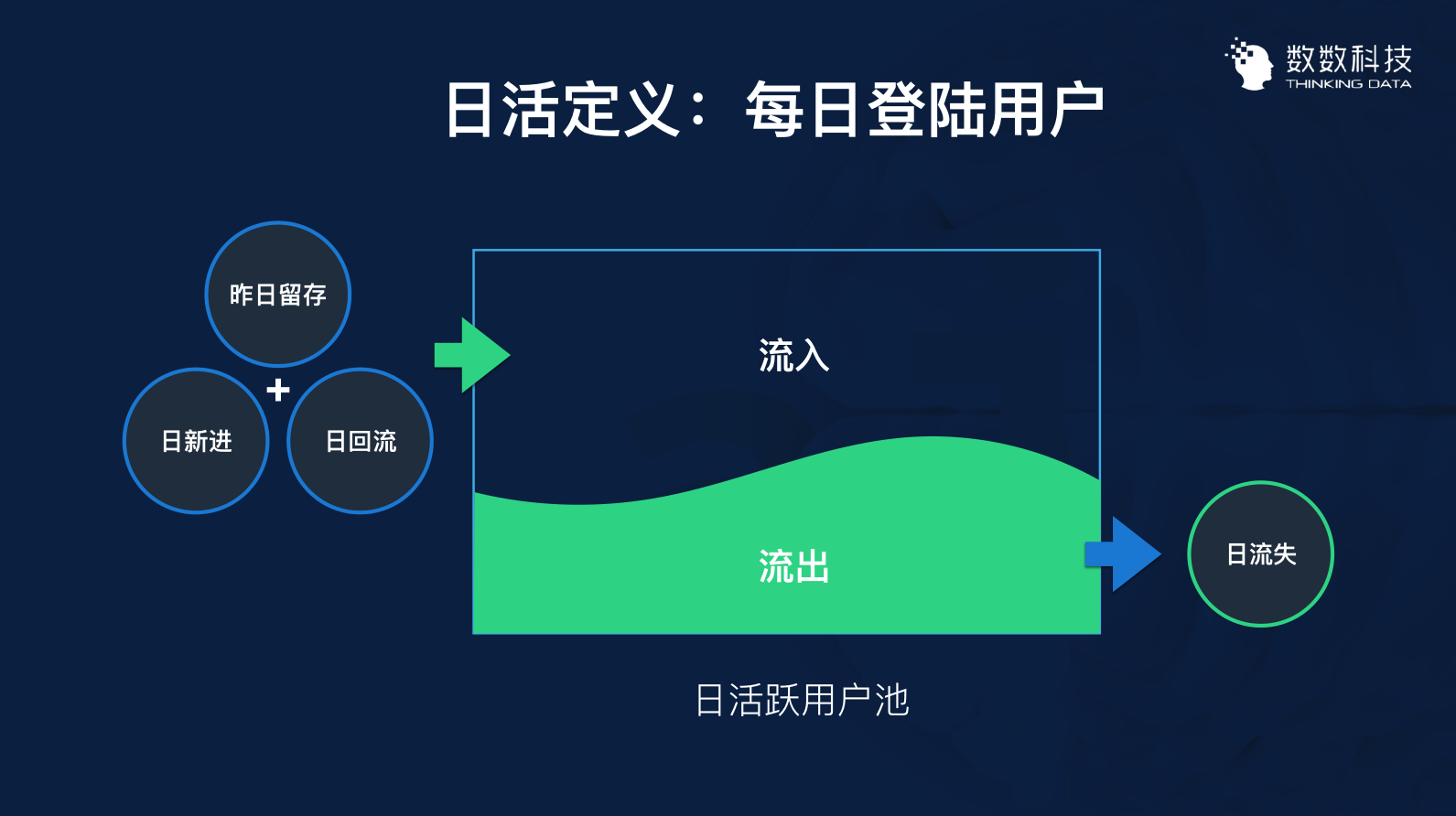

为了预测这个DAU,首先我们需要对流程做一个拆解,我们首先需要定义它。每日登录用户,就是DAU的定义,只要用户做了登陆操作,我们就认为他是一个活跃用户,每天DAU的曲线波动非常大。

造成DAU波动的因素由这几个点构成,通常我们把整个日活的用户比喻成用户池,每天都有流入的用户,每天都有出去的用户。所以一个流入一个流出形成了数据的波动,对于流入的部分我们可以分为三个部分:昨日留存用户+日回流用户+日新进用户。

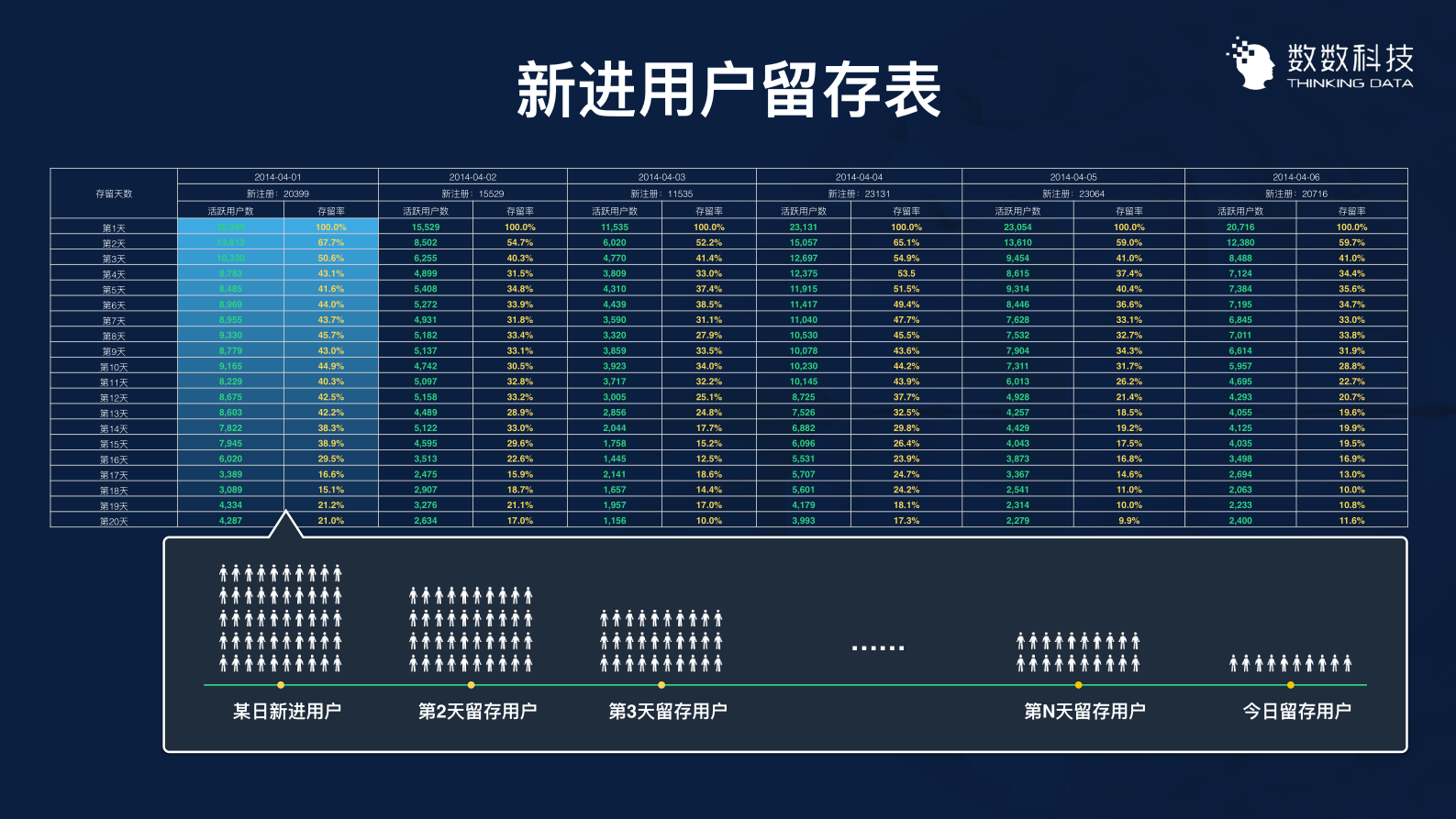

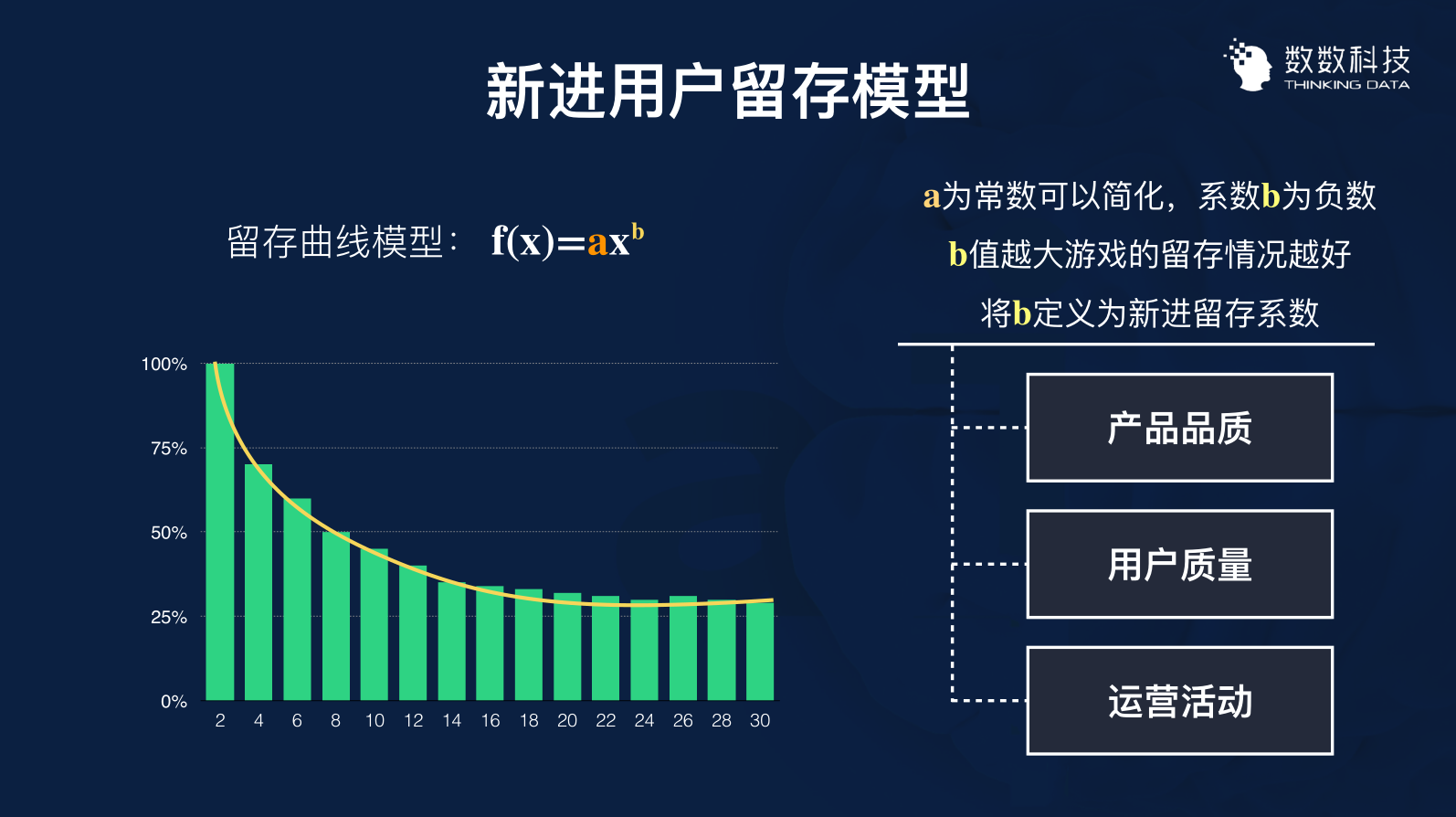

分解之后,我们就可以完成一张新进用户的留存表。

表格一共列举了5天内有多少人留下来,在后续20天每天又有多少人留下来了。我们会发现里面的留存率,是根据下方示意图的趋势发展的,呈现的是衰减的趋势。

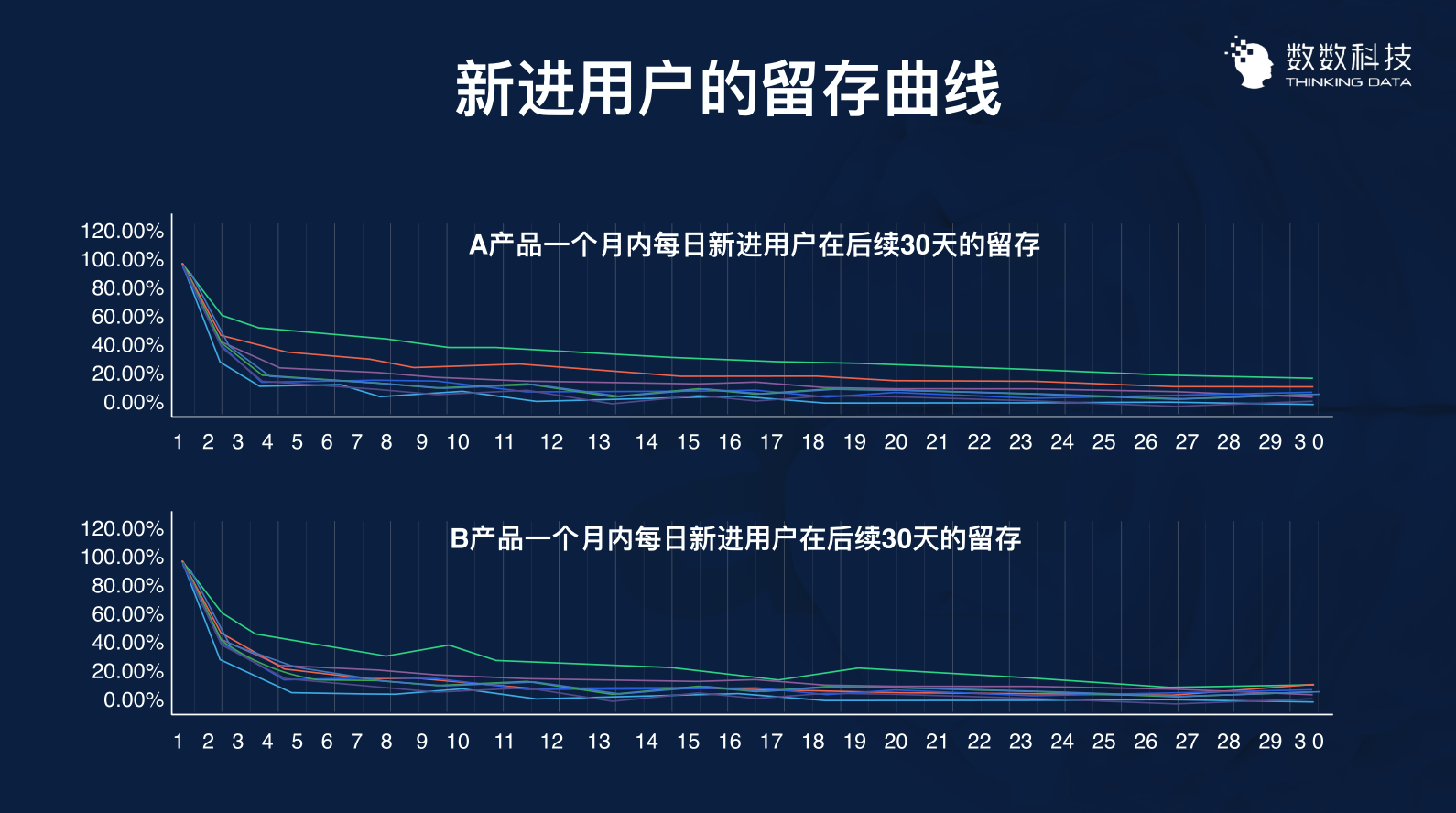

然后我们找来两个产品的留存曲线来拟合这个衰减现象。

大家可以看到这两个曲线还是挺有规律的,相对来说也是较为平滑的,这个时候我们需要选择一个留存模型——幂率分布对它进行预测。

其中:

- a为常数(可简化)

- b为新进留存系数

- x为产品运行天数

如果b的值越大,留存情况就会越好,因为b这个值决定了曲线的倾斜程度,比如A产品第一条绿线的b值就要大于红线。

所以b值就可以反映出产品的用户留存特征,我们就可以把b定义为新进的留存系数,留存系数可以通过三个点决定:

- 产品的品质

- 用户的质量

- 运营的活动

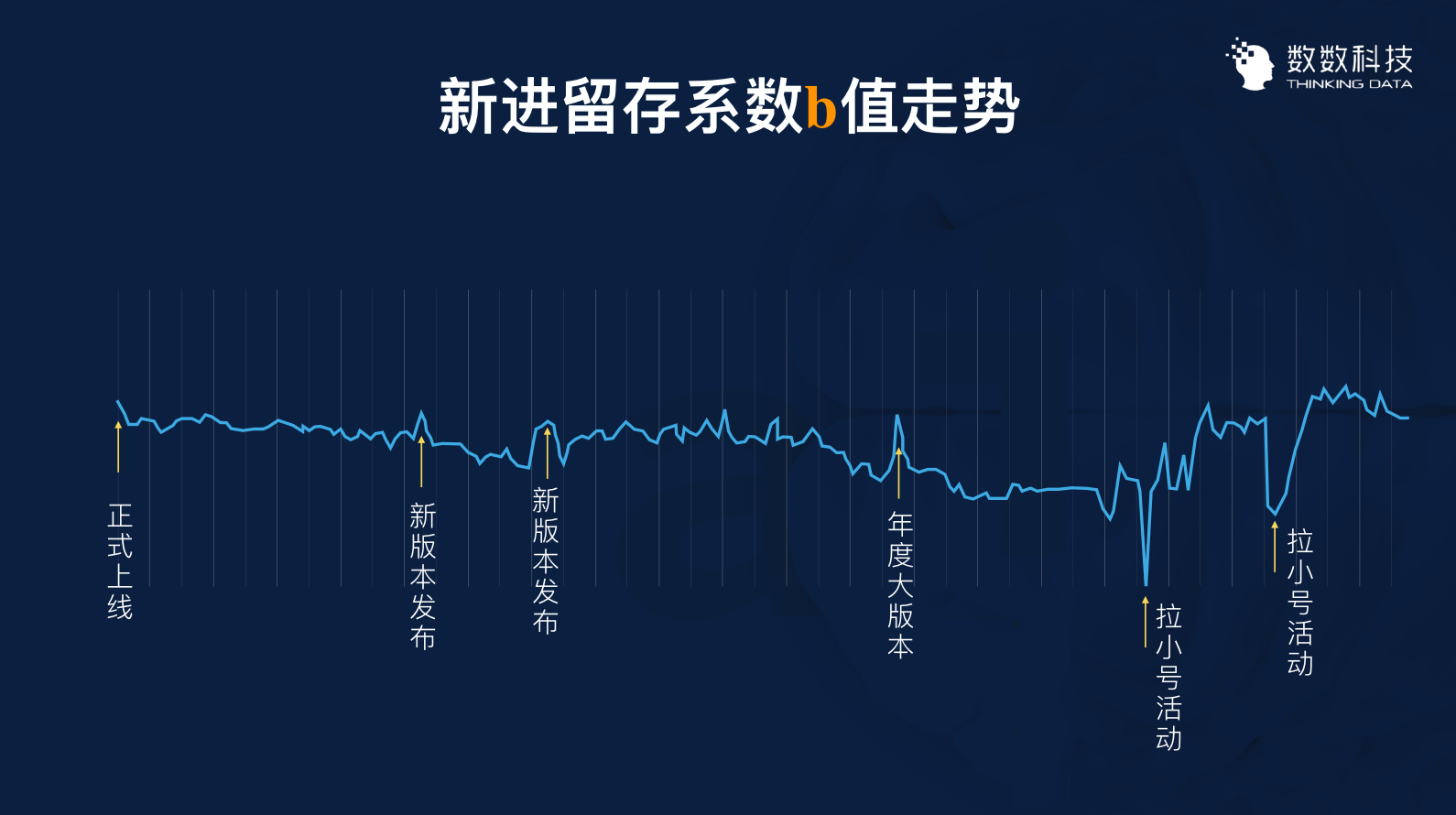

在结合上述理论后,我们就可以从已经运营一段时间的产品中抓取我们产品的b值,画一个走势图。

这该产品b值一年来的走势图。从大的层面来看,b值的波动不是非常的大,但是波峰和波谷都有相关运营活动或者版本迭代的干预,导致了这个值的改变。

图上显示,我们为了完成某些KPI去提高DAU值做的拉小号的活动,反而导致了b值的下降,就证明拉小号的活动促进了DAU的值上升,但用户质量却下降了。产品本身的质量其实是比较稳定的,你可以衡量它的用户质量,用户质量其实就与运营活动质量有关。

有了这样的模型之后,我们就可以计算出把DAU的公式列举出来了。

大家可以把这个概念不停拆分下去,累加之后就可以形成DAU公式。我们可以把总的日活数据不停地拆,从第一天到第N天留存用户数,就可以得到今日的日活。然后我们再利用这个公式,去做出我们产品的走势图。

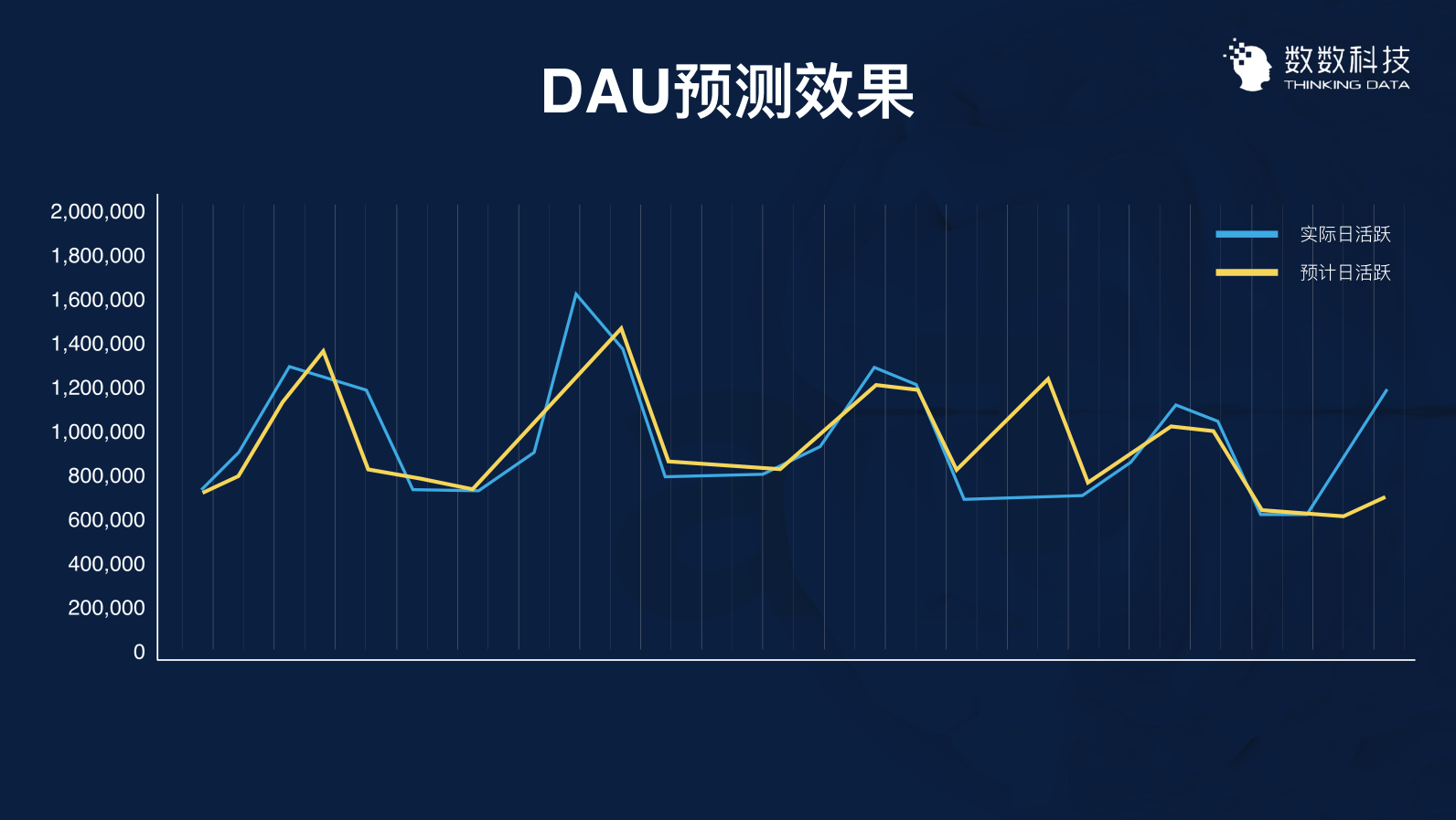

根据这样的情况,我们就可以很好地去预测DAU的走势,去对比实际日活和预测日活的一个匹配程度。虽然存在一些偏差,但是偏差值也是因为受到活动的影响才发生的。

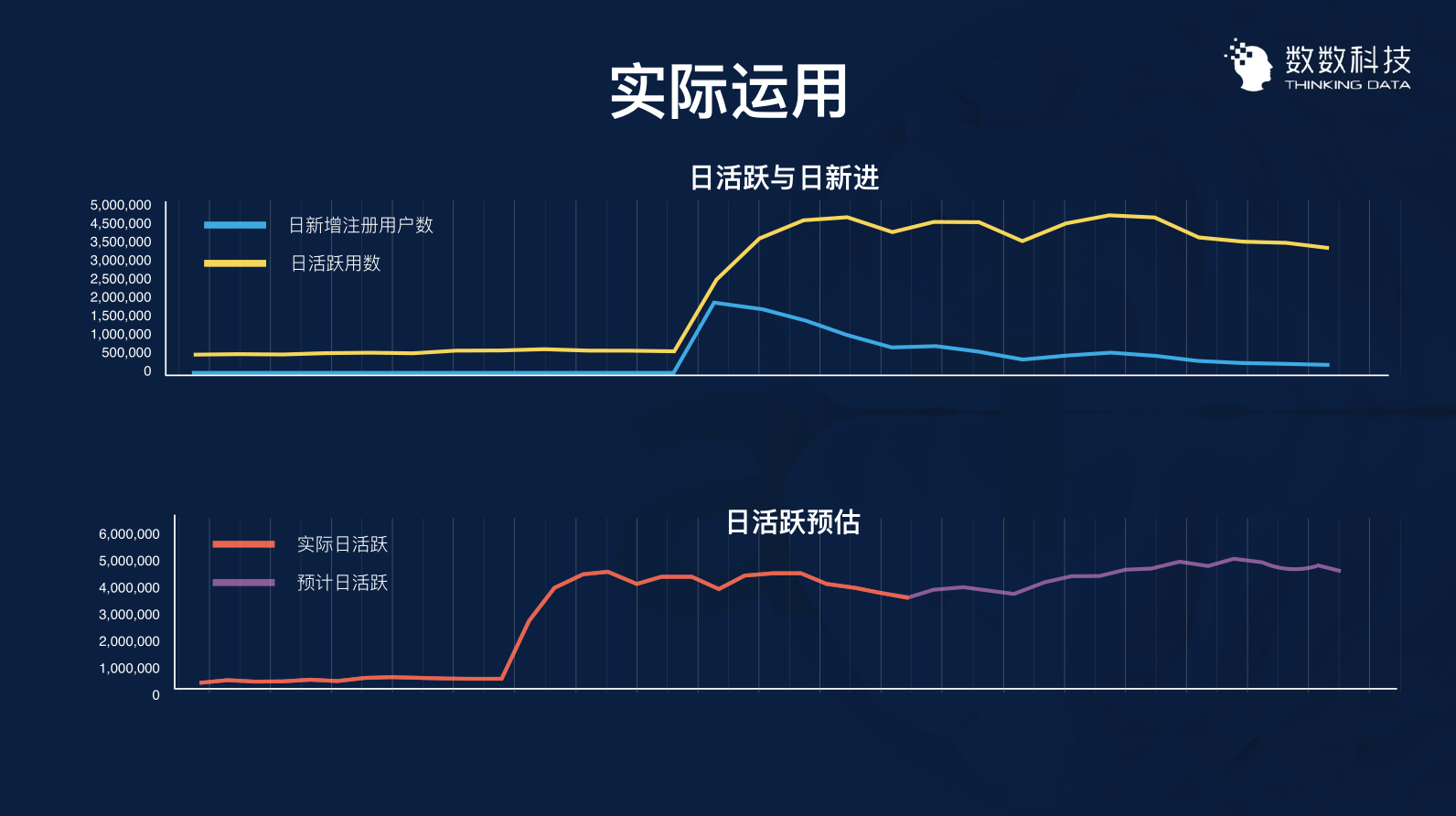

获取预测趋势图之后,我们再投入实际的应用中去评估。

我们回到评估DAU50万的目标上。

从上图可以看到上面这张图是日活跃与日新进的走势关系,这些都是不限号之前的走势,不限号之前是比较稳定的,核心玩家一直都是比较稳定的,没有什么比较大的变化。中间拐点开始是不限号当天出现的,日新增注册用户自拐点之后一直往下走。

我们代入那个日活公式后,下方图的紫色部分就代表我们的预计的日活曲线。最后推算出来是,我们需要连续两周每天都要有8万的新进,才能够完成50万DAU的指标。

这个数值所需要的费用跟我们实际的预算相比差距太大,因此我们放弃了用50万去投放买量的计划。如果差距不大的话,我们才会选择投放获客。

这次的数据挖掘就给了我们此次决策的数据支撑,告诉了我们这个决策是不具备可行性的。后来为了完成目标,我们改用了拉小号的活动,将数据快速地推上去。

总结下来,数据挖掘可以分为三步:

- 利用历史数据

- 建立概念模型

- 预测发展趋势